3. 如何搭建异地多活架构?

3. 如何搭建异地多活架构?

大家好,我是牛哥。

在分布式系统架构的进阶之路上,「异地多活」始终是绕不开的重要课题。

“如果核心机房因突发灾害宕机,如何确保用户支付、下单等核心操作不受影响?”

起初碰到这类问题时,我也仅能从”数据备份、主备切换“等表层概念作答,面试官再深入下去就卡壳。

直到后来参与了公司异地多活架构的搭建,才真正摸透其中的核心逻辑。

今天的这篇文章,全是实战里攒下的技术细节。对于准备面试的开发者而言,掌握这些内容不仅能从容应对提问,更能在实际工作中理解「异地多活」的底层逻辑 — 这也是我想真诚分享的初衷。

什么是异地多活?

在分布式系统里,故障从不是 “会不会发生” 的问题,而是 “什么时候发生”的问题。想象一下这样的场景:

想象一下这样的场景:

你正在使用支付宝进行一笔重要的转账操作,突然北京机房因为地震、火灾或者网络故障导致整个系统瘫痪。这个时候,如果你在北京,可能连基本的支付功能都无法使用,更别说转账了。

再想象另一个场景:

双11购物节,淘宝的服务器因为流量过大而崩溃,全国几亿用户都无法下单,商家损失惨重,用户购物体验极差。

在系统稳定性要求越来越高的今天,这种故障的代价是沉重的。对于金融、电商、社交这些核心场景,哪怕是 1 分钟的中断都可能引发用户流失。

比如支付系统卡 10 秒,就会有用户转而用竞品;社交软件崩 5 分钟,热搜上可能就会出现负面话题。

在这种环境下,异地多活架构应运而生。它通过在多个不同地理位置部署相同的服务,能够确保:

即使某个地区的机房完全瘫痪,其他地区的服务依然正常运行,用户几乎感受不到任何影响。

不过,异地多活架构并非生来完备,如今的成熟模样也是经历了一系列演进而来的。

异地多活架构演进之路

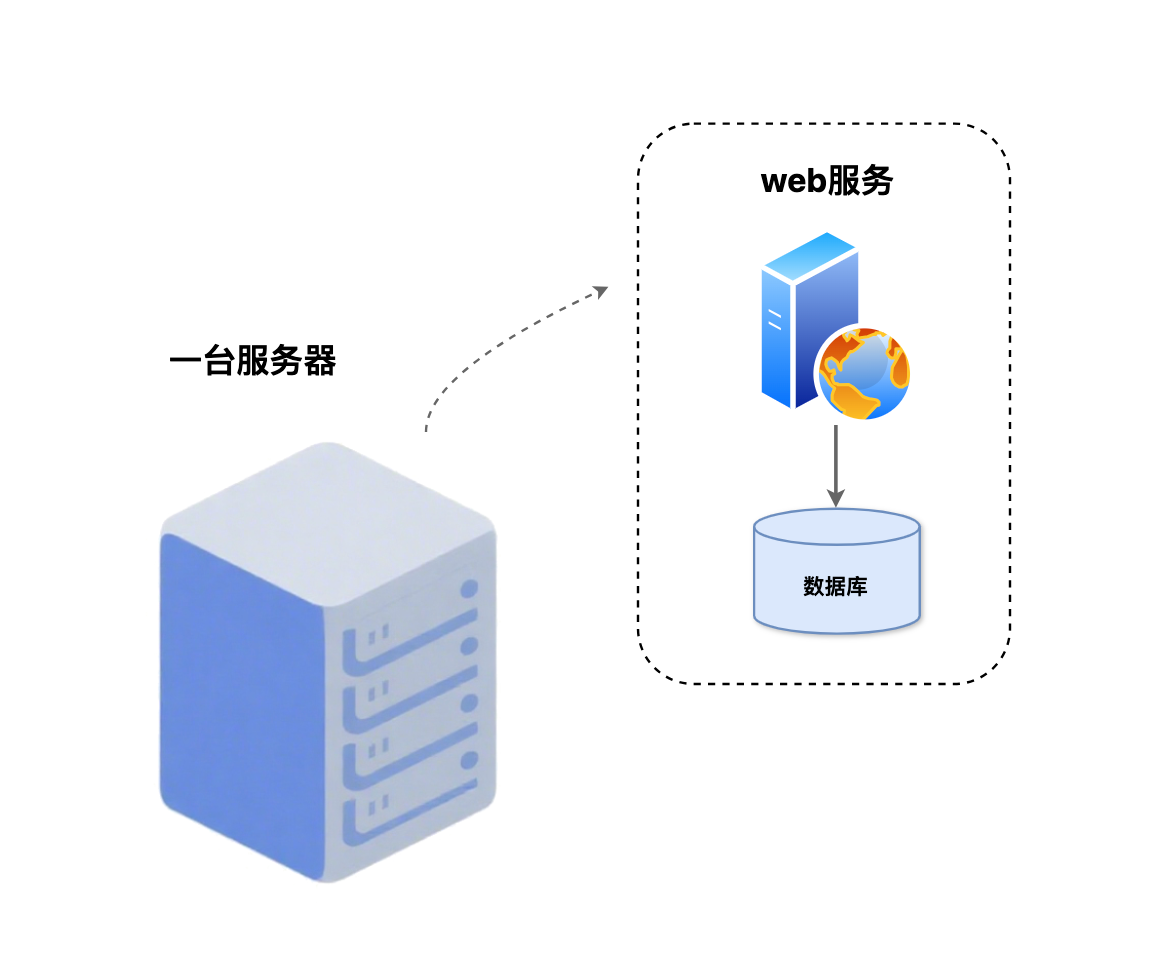

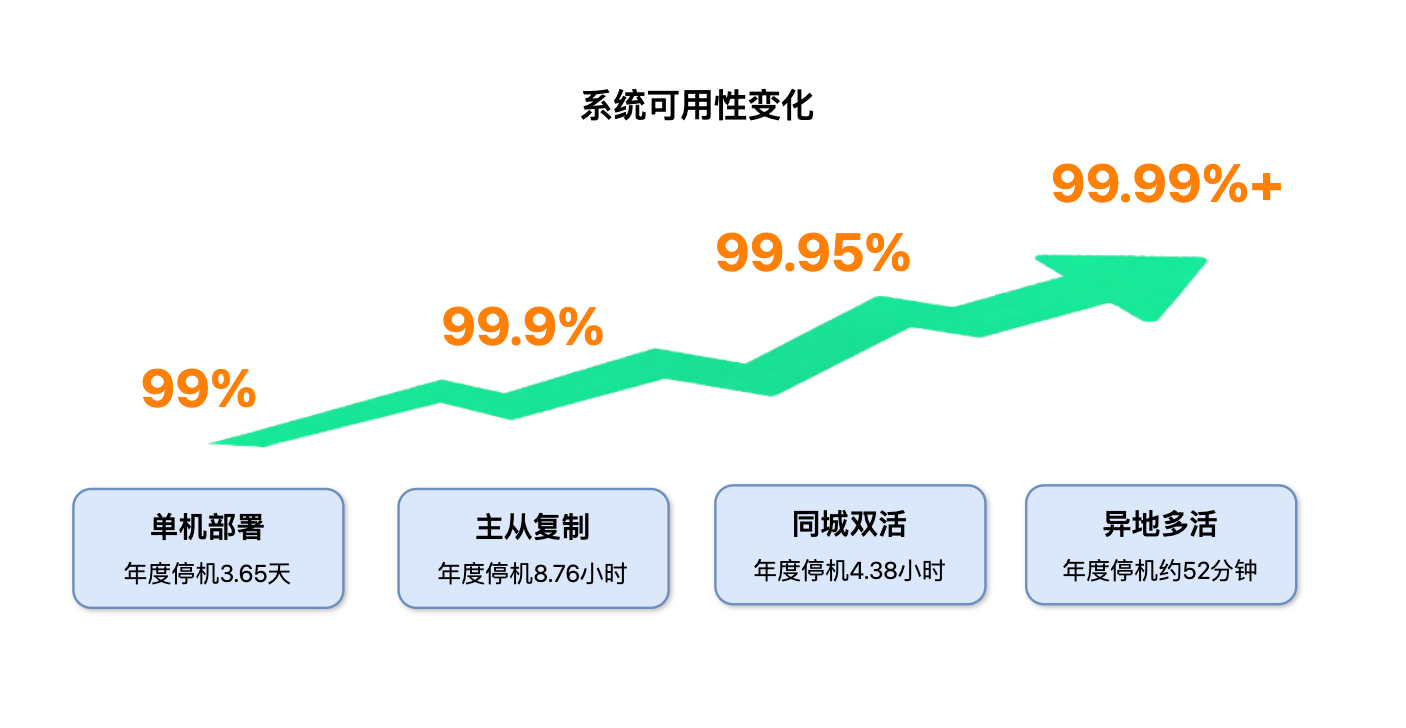

单机时代:简单但脆弱(99%可用性)

在互联网发展的早期,大多数系统都采用单机部署的方式:

一台服务器承载整个应用,包括Web服务、数据库、缓存等所有组件。

这种架构的特点十分鲜明,所有服务无需分散配置,仅在一台机器上即可完成部署,搭建时也只需投入一台服务器,整体逻辑简单直接,前期开发与后期维护成本都很低。

但单机架构的脆弱性也很明显:

- 单机架构存在单点故障问题,一旦服务器宕机,整个系统就瘫痪了;

- 同时容量有限,无法应对高并发和大流量的挑战;

- 此外扩展困难,只能通过升级硬件来提升性能,缺乏灵活性。

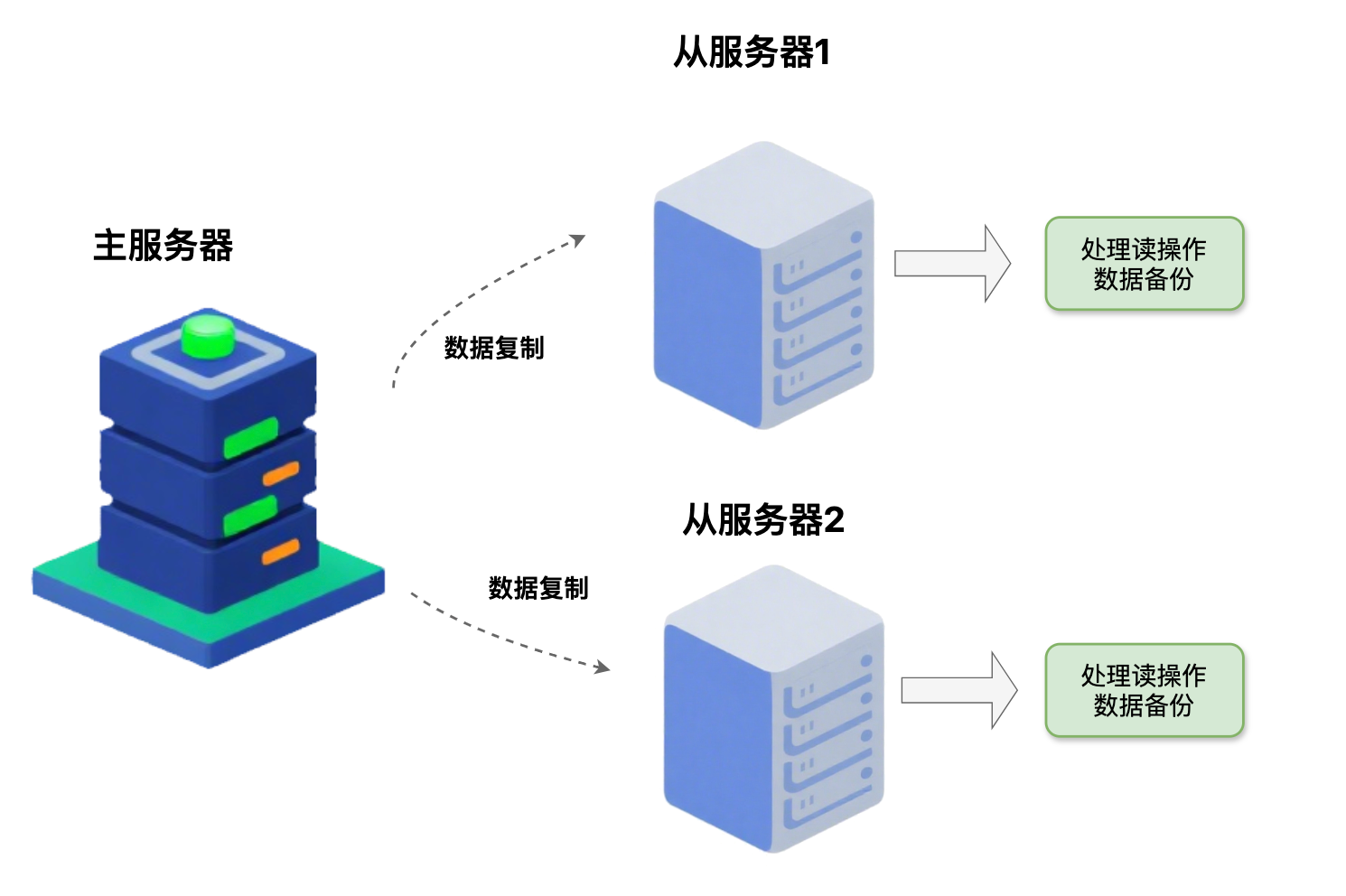

主从复制:读写分离,部分容错(99.9%可用性)

随着业务的发展,单机架构已经无法满足需求。主从复制架构应运而生:

通过增加一台从服务器来提供备份和读写分离能力。

主服务器负责处理写操作与部分读操作,从服务器通过复制主服务器数据实现备份,同时主要承担读操作,为核心服务器分担压力。

这种架构设计巧妙地解决了单机架构的单点故障问题,通过数据复制机制确保了数据的可靠性,当主服务器故障时有备份数据可用。

但主从架构仍有局限性:

- 主从切换存在延迟问题,切换过程中服务可能中断;

- 主从同步存在延迟,可能导致最新数据丢失;

- 主从服务器通常部署在同一机房,无法应对机房级别的故障。

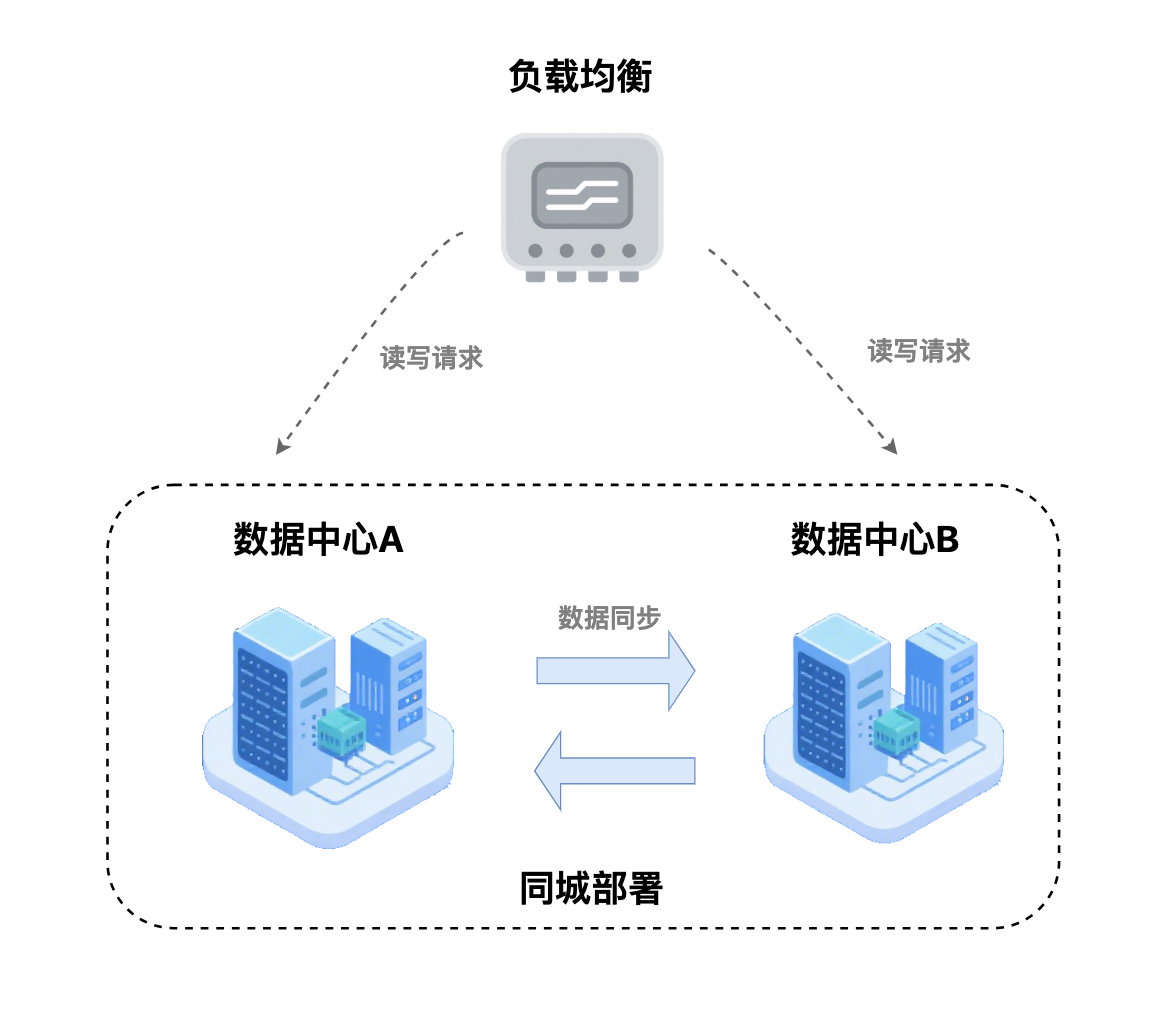

同城双活:本地高可用(99.95%可用性)

同城双活是在主从架构基础上的进一步改进:

两台服务器都部署在同一个城市,但都能独立处理用户请求。

同城双活的特点十分明确:两台服务器可并行处理请求,搭配负载均衡器实现请求分发,同时保持数据实时同步,一旦某台服务器故障,还能快速切换至另一台继续服务。

同城双活带来了显著的优势:单台服务器故障不会影响整体服务,实现了高可用性;两台服务器分担负载,显著提升了系统性能;故障切换时间通常在秒级,确保了快速恢复能力。

然而,同城双活也存在一些不足:

- 同城风险:地震、火灾等城市级灾难会影响两台服务器;

- 网络依赖较高:两台服务器间的网络故障会影响数据同步;

- 成本相对较高:需要两台服务器和复杂的同步机制;

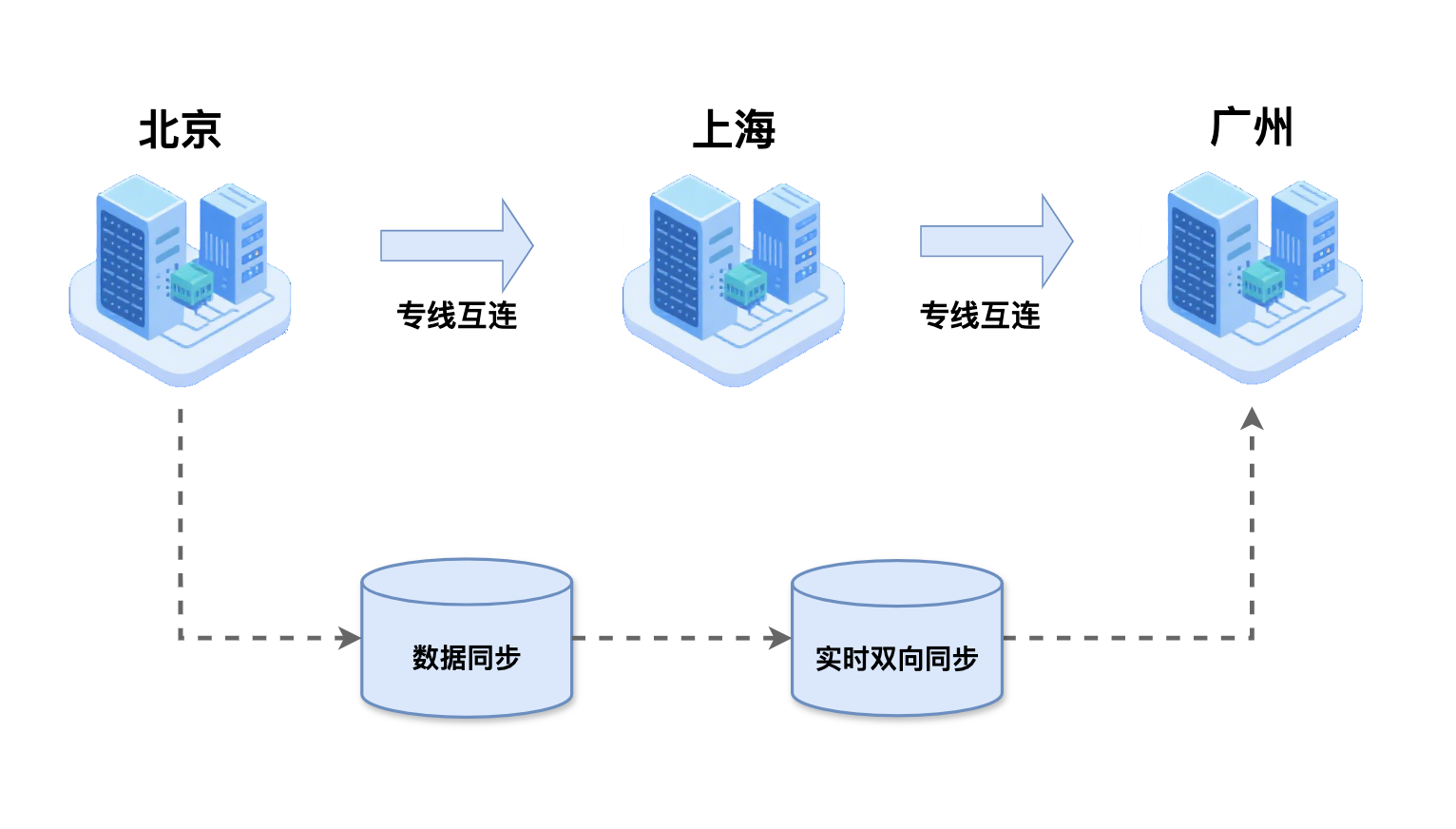

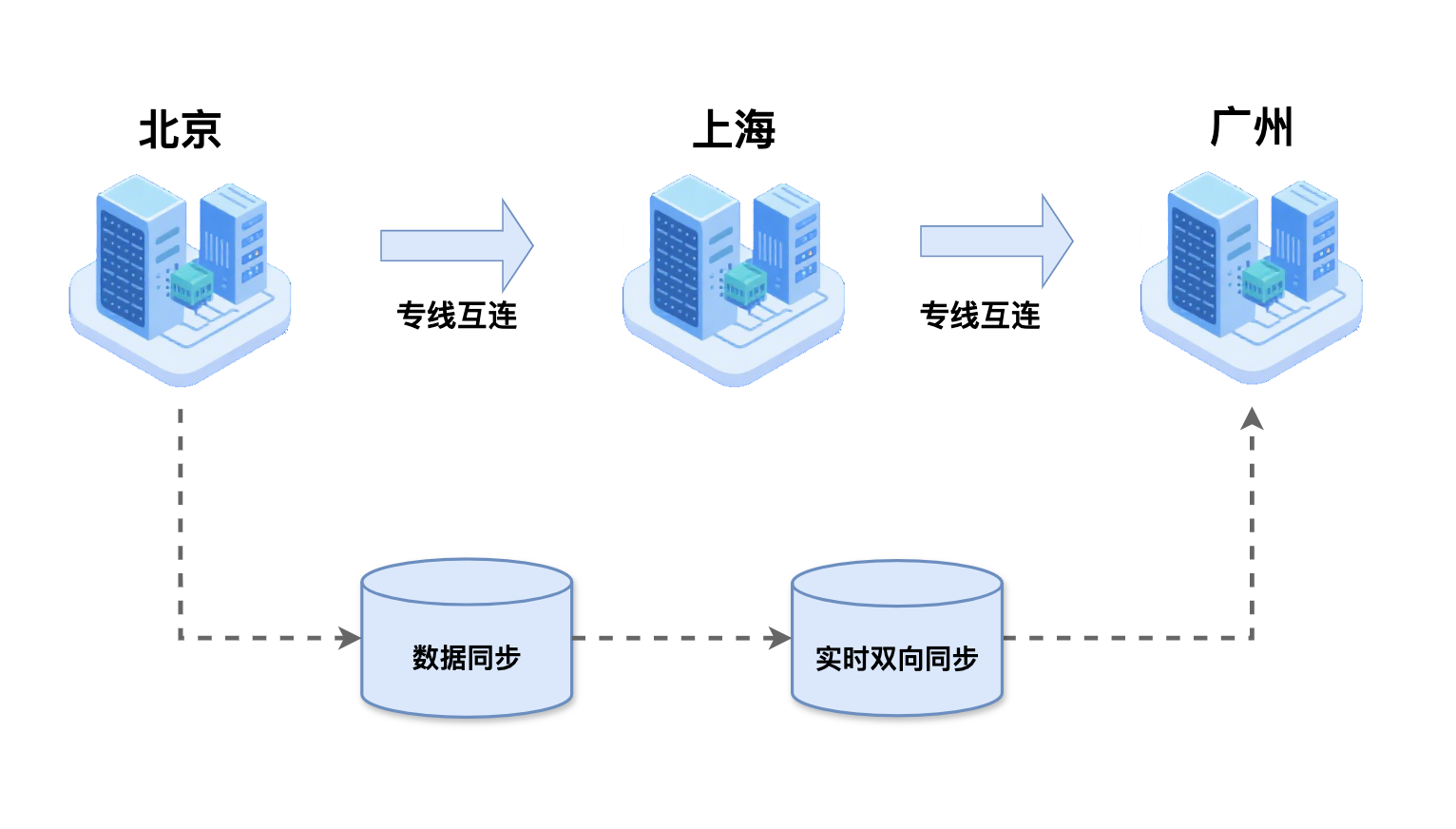

异地多活:真正容灾(99.99%+可用性)

随着业务规模的不断扩大,单一城市的容量和带宽限制已经无法满足快速增长的需求,进一步演进出了异地多活架构:

通过地理分散部署的方式,不仅能够有效应对城市级灾难,还为用户提供了就近访问的便利,同时实现了系统的无限扩展能力。

异地多活具有五个核心特征:

- 服务部署在不同城市或地区,实现地理分散;

- 所有节点都在处理用户请求,实现同时在线;

- 跨地域的数据实时同步,确保数据一致性;

- 结合用户地理位置,实现就近流量调度;

- 故障时自动切换到健康节点,实现智能容灾;

- 异地多活作为架构演进的最终形态,实现了真正的容灾能力。

演进总结:

从单机部署到主从复制,再到同城双活,最终到异地多活,每一次演进都伴随着系统可用性的提升;

这个演进过程也深刻反映了互联网技术发展的必然趋势:从单体架构到分布式架构,从单点部署到多地域部署,从被动容灾到主动高可用;虽然技术架构的复杂度在不断提升,但系统的稳定性和用户体验也在持续改善。

异地多活难在哪儿?

虽然异地多活架构解决了单点故障和城市级灾难问题,但实际落地远比想象中复杂。

从表面上看,异地多活只是在多个地方部署相同的服务,然而,在实施异地多活时,很多团队都会面临各种挑战。下面牛哥带大家来看几个最具代表性的挑战:

1.数据一致性问题

如何保证不同地区的数据完全一致?比如用户在北京下单后,在上海查询订单时能否看到最新的状态?

2.数据冲突问题

如何处理网络延迟导致的数据冲突?比如用户在北京和上海同时修改了同一个商品的价格,最终应该以哪个为准?

3.故障切换问题

如何在故障发生时快速切换而不影响用户体验?比如北京机房突然断电,如何让用户无感知地切换到上海机房?如何确保切换过程中数据不丢失?

4.一致性与性能平衡问题

如何平衡一致性和性能的关系?比如银行转账时,是优先保证数据一致性还是优先保证响应速度?不同业务场景下应该如何选择?

5.成本控制问题

如何控制多地域部署的成本?比如部署到5个城市需要多少服务器、多少带宽、多少运维人员?如何在保证可用性的前提下优化成本?

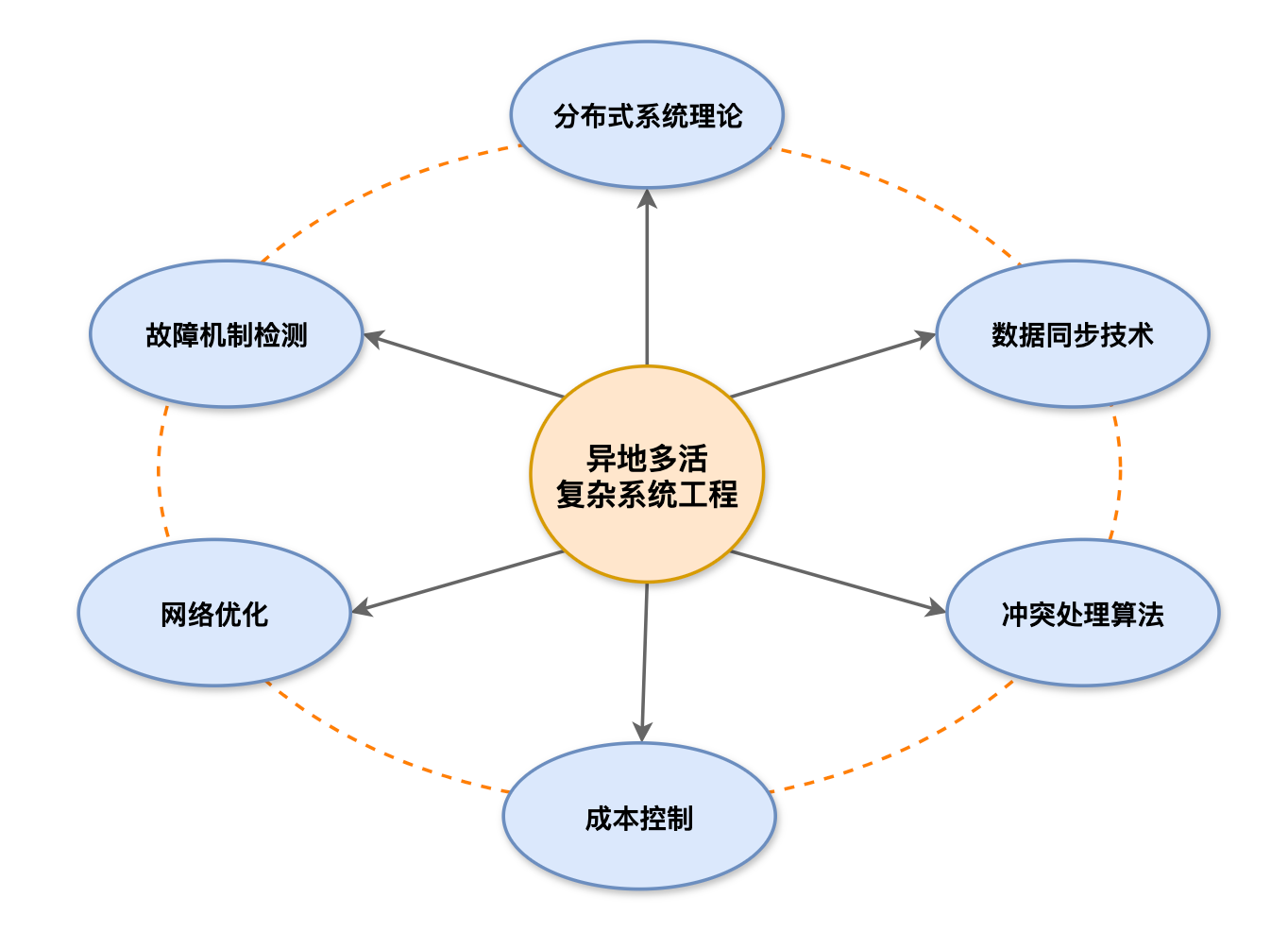

要解决这些问题,我们需要明确:

异地多活绝非简单的多地域部署,而是一项涉及分布式系统理论、数据同步技术、冲突处理算法、故障检测机制、网络优化、成本控制等多个复杂技术领域的系统工程。

每一个技术点都可能成为系统的瓶颈,每一个细节都可能影响整个架构的稳定性。

接下来,牛哥将根据这些难点一一为大家做技术拆解

核心技术拆解

数据一致性

理解异地多活的关键,绕不开分布式系统的基石 — CAP 理论

它告诉我们,在分布式系统中,我们无法同时满足三个理想特性:

1.一致性(Consistency):所有节点看到相同的数据

就像银行账户,无论你在哪个网点查询,余额都应该是一样的

2.可用性(Availability):系统持续提供服务

无论发生什么故障,系统都能响应用户请求,用户不会看到"系统维护中"的提示

3.分区容错性(Partition tolerance):网络故障时仍能工作

即使网络断开,系统也能继续运行

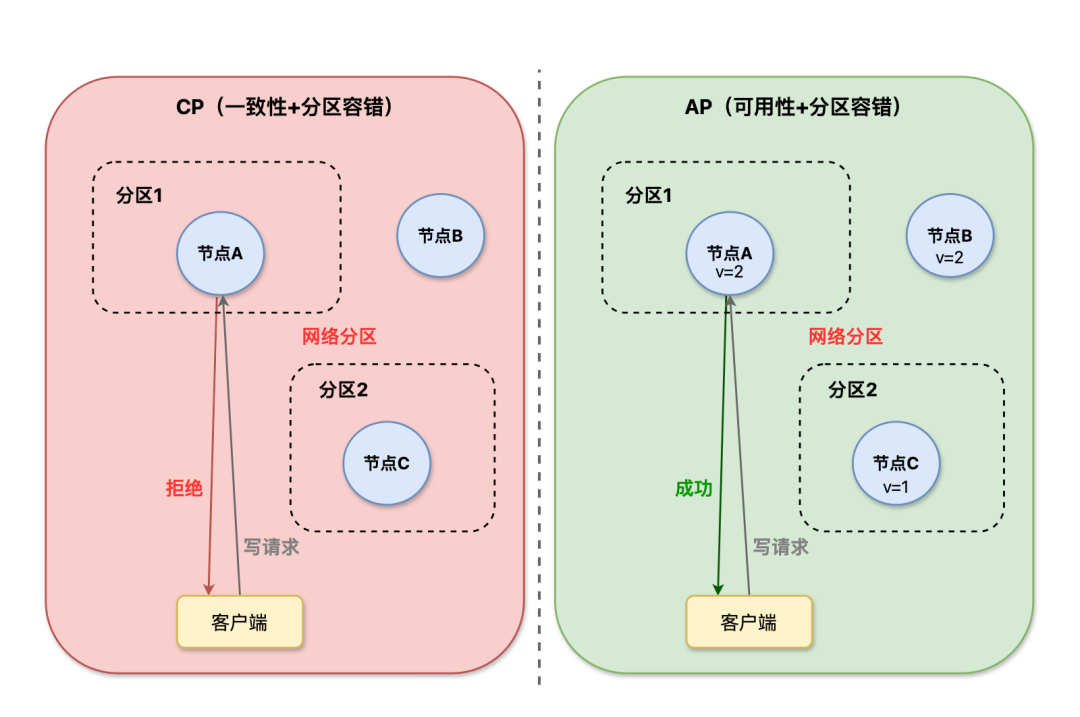

当网络出现问题时,我们必须在一致性和可用性之间做出选择:

- 选择CP(一致性+分区容错):保证数据一致,但可能暂时不可用

- 选择AP(可用性+分区容错):保证服务可用,但数据可能暂时不一致

在实际选择中,为什么多数系统选择AP而非CP?因为:

- 用户体验更重要:用户宁愿看到稍微过时的数据,也不愿意看到"系统不可用"

- 最终一致性可接受:数据最终会同步,短暂的不一致是可以容忍的

- 业务连续性:保证服务不中断,避免经济损失

不过,无论是选择AP还是CP,在理论的落地实施中,都离不开数据同步策略的支撑。

接下来,我们把重点聚焦于数据同步策略:

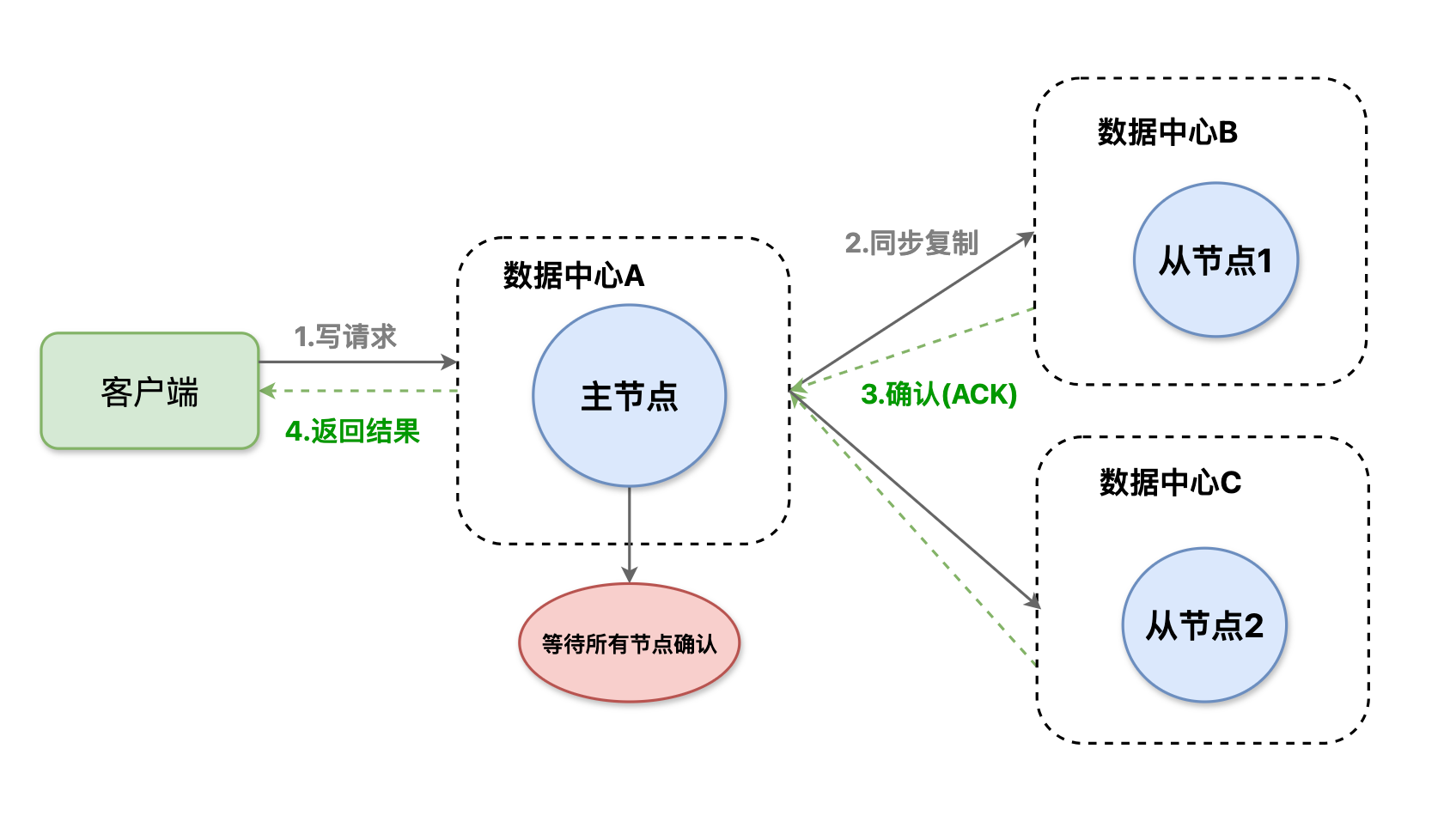

策略一:同步复制(强一致性)

同步复制的工作原理是:

写操作必须等待所有节点都确认后才返回成功。

就像开会做决定时必须所有人都同意才算通过,虽然决策很可靠,但效率很低。

同步复制的优势在于数据绝对一致,所有节点数据完全相同,同时实现简单可靠,不需要复杂的冲突处理机制。

然而,同步复制也存在明显的不足:延迟较高,需要等待所有节点响应;可用性较差,任何一个节点故障都会影响写操作。

适用场景:对数据一致性要求极高的金融核心业务,如银行转账、证券交易等场景。

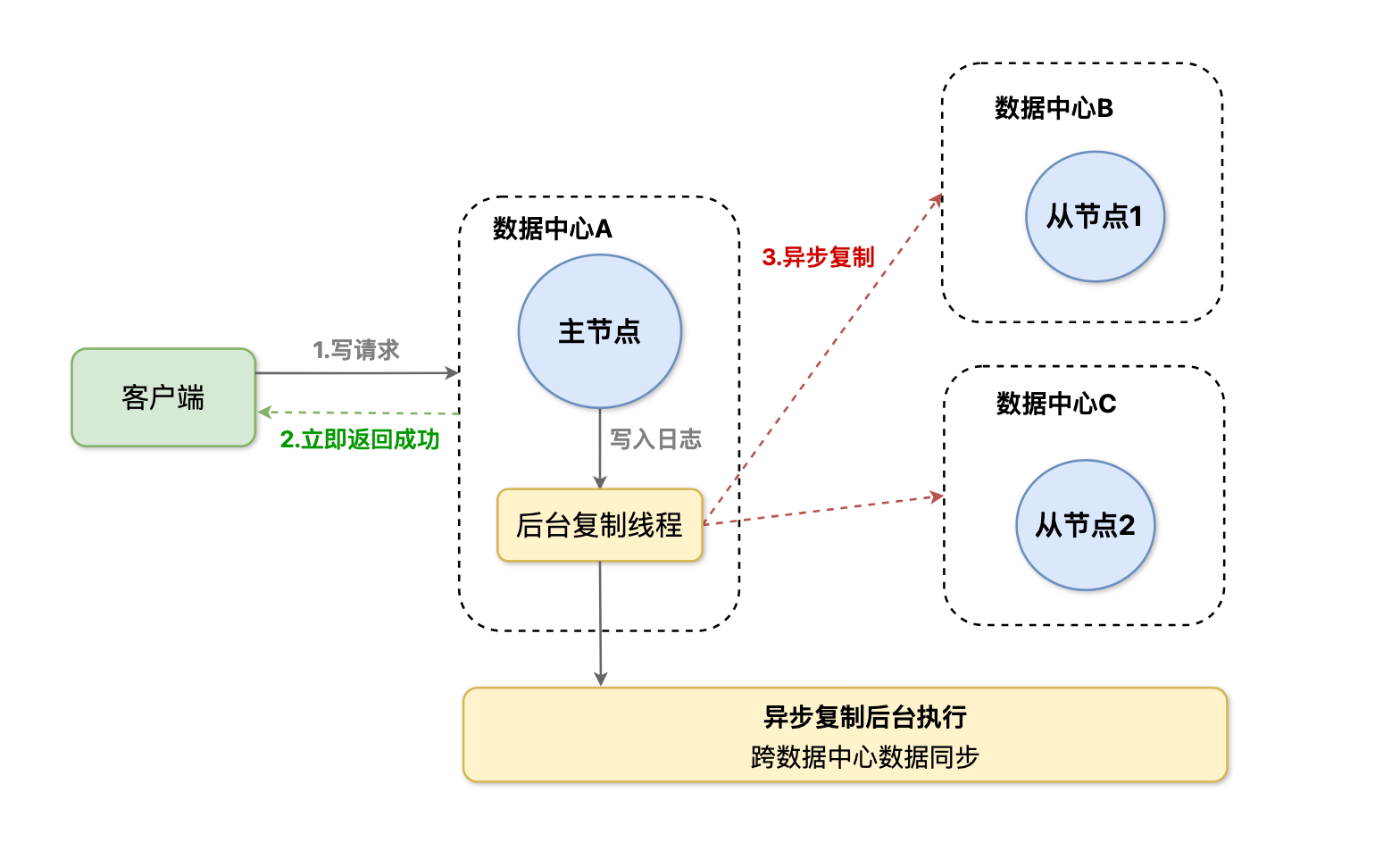

策略二:异步复制(最终一致性)

异步复制的工作原理是:

写操作立即返回成功,数据在后台异步同步到其他节点。

就像发微信时你发送后立即显示"已发送",但对方可能稍后才收到,虽然可能延迟,但不会影响你的使用。

异步复制的优势在于性能表现优秀,写操作响应速度快,同时可用性高,单个节点故障不会影响写操作。

然而,异步复制也存在一些不足:同步期间可能出现短暂的数据不一致,同时冲突处理相对复杂,需要解决数据冲突问题。

适用场景:对实时性要求不高但对性能要求较高的社交、内容类业务,如微博、新闻等场景。

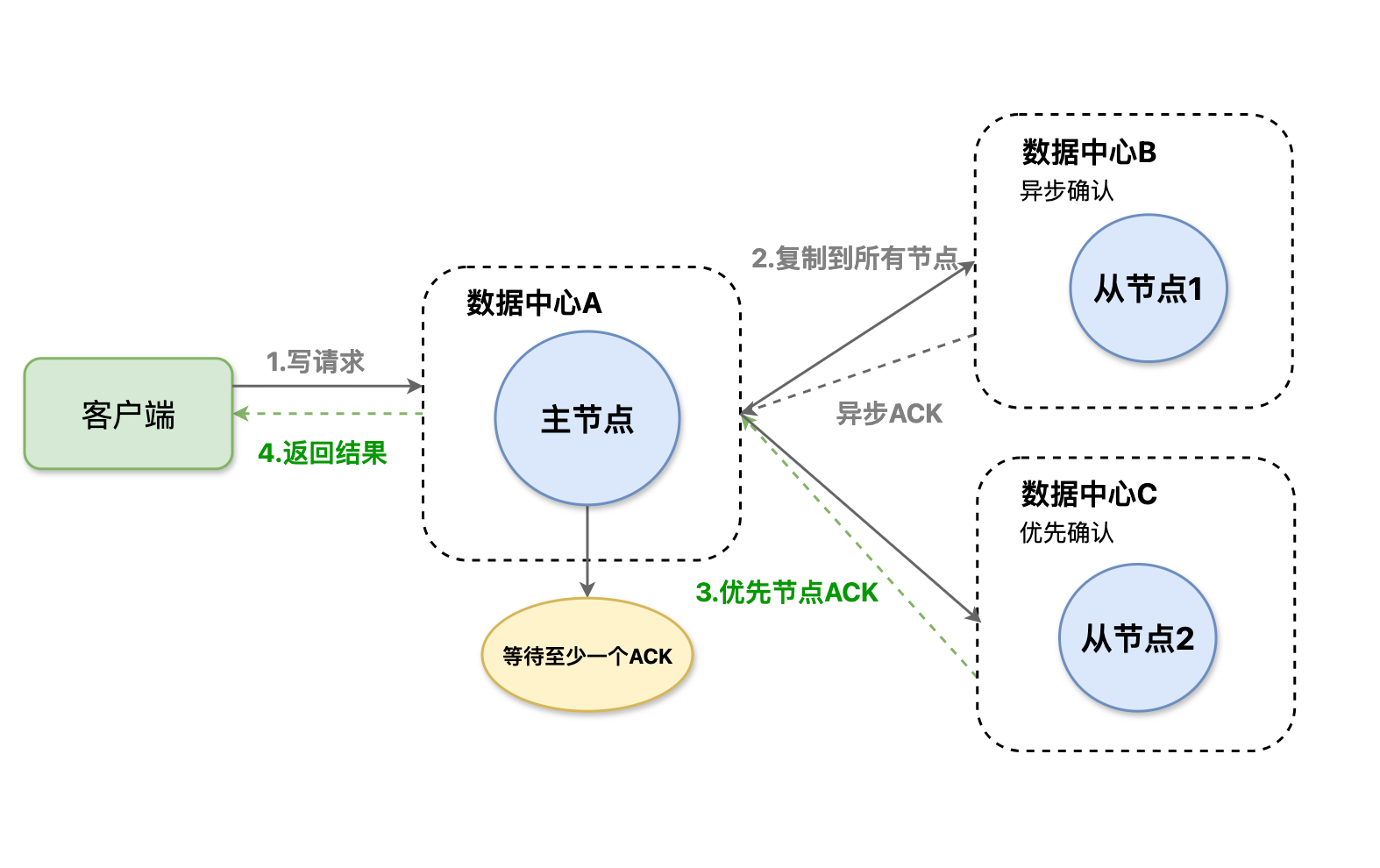

策略三:半同步复制(平衡方案)

半同步复制的工作原理是:

写操作必须等待部分节点(通常是多数节点)确认后才返回成功。

就像投票表决时只要超过半数人同意就算通过,既保证了决策的可靠性,又提高了效率。

半同步复制的优势在于既保证了数据的一致性,又提供了较好的性能表现,避免了同步复制的低效和异步复制的不一致问题。

核心思想是在一致性和性能之间找到平衡点。避免了同步复制的低效和异步复制的不一致问题。

适用场景:对性能和一致性都有要求的业务场景,如电商下单扣库存、游戏道具购买等场景。

了解了这些同步策略,回到之前提出的问题:

“用户在北京下了单,随后在上海查询订单,能实时看到最新的订单状态吗?”

答案就藏在我们选择的同步策略里:

- 选同步复制,用户在上海查询时一定能看到最新状态,但这就意味着北京的下单响应会较慢;

- 选异步复制,北京下单响应快,但在上海查询时可能看到稍旧的数据;

- 如果选半同步复制,则能在响应速度和数据一致性之间取得平衡。

然而无论采用何种同步策略,数据冲突始终是绕不开的核心问题;尤其在异步复制场景中,由于数据同步存在延迟,数据冲突几乎难以避免。

接下来,牛哥带大家看看解决数据冲突有哪些可行策略。

数据冲突解决策略

在异步复制中,数据冲突是不可避免的。当多个节点同时修改同一份数据时,就会出现冲突。如何优雅地解决这些冲突,是异地多活的关键技术。

1. 时间戳策略

每次数据修改时记录修改的时间戳,当发生冲突时比较时间戳并选择最新的数据,时间戳可以是物理时间或逻辑时间。

物理时钟 vs 逻辑时钟:

- 物理时钟:使用真实时间,简单直观,但可能因为网络延迟而不准确

- 逻辑时钟:使用递增的计数器,保证因果关系的正确性,但实现复杂

时间戳策略的优势在于实现简单,容易理解,但缺点是依赖时钟同步,网络延迟可能导致判断错误。

典型业务场景:

比如之前提到的问题,比如用户在北京和上海同时修改了同一个商品的价格,最终应该以哪个为准?

- 北京修改时间:14:30:01

- 上海修改时间:14:30:05

- 最终结果:采用上海的价格(时间戳更晚)

2. 版本号策略

每次数据修改时版本号自动递增,冲突时比较版本号并选择版本号大的数据,版本号必须保证单调递增且不能重复。

分布式版本号生成算法:

- 雪花算法:结合时间戳、机器ID、序列号,保证全局唯一

- UUID:全局唯一标识符,但长度较长

- 数据库自增ID:简单可靠,但依赖数据库

实际应用场景:

比如文档协作编辑:

- 用户A编辑版本:v1.2

- 用户B编辑版本:v1.3

- 最终结果:采用v1.3版本的内容

版本号策略的优势在于不依赖时钟,逻辑清晰,但缺点是需要额外的版本号管理机制。

3. 业务规则策略

业务规则策略的核心思想是根据业务语义来解决冲突,而不是简单的技术规则。但这需要我们更加深入理解业务。

以上的策略可以成功解决冲突,保障数据准确性,但服务的持续可用性同样需要保障,毕竟硬件、网络或环境异常都可能导致服务中断。

所以我们继续聊聊架构稳定性的另一重要支撑 — 故障检测与切换。

故障检测与切换

在异地多活架构中,硬件故障、网络分区、机房断电、自然灾害等都可能导致某个地区的服务不可用。因此故障检测和自动切换显得尤为重要。

故障检测与切换涉及三个关键技术环节:故障检测算法、切换决策机制和数据恢复策略。

1. 故障检测算法

目前主流的故障检测算法,主要围绕心跳检测、业务健康检查、网络分区检测这三类核心方式展开,它们各有侧重又能相互配合,确保故障 “早发现、少误判”。

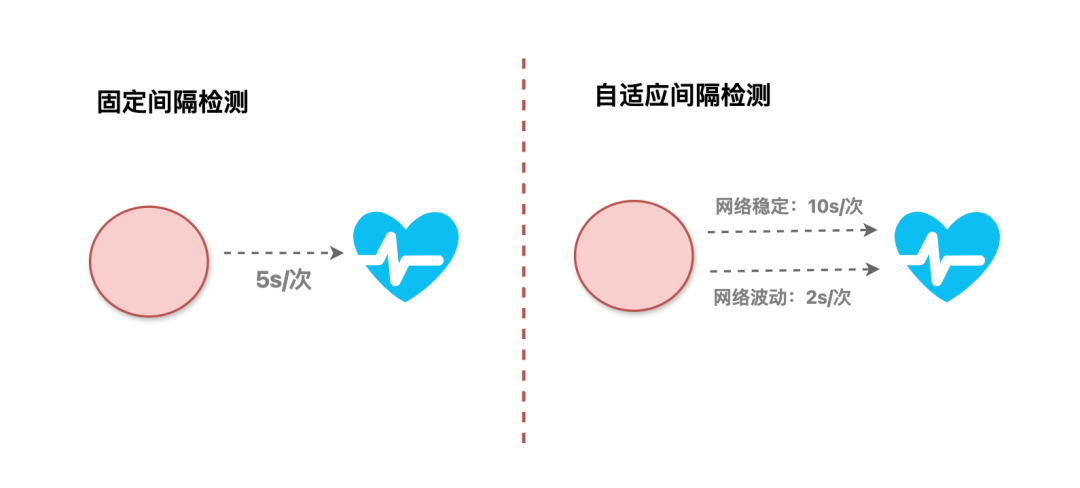

心跳检测里固定间隔检测最常用,比如每 5 秒发一次心跳,简单直接;自适应间隔检测则更灵活,网络稳定时放宽至 10 秒一次,波动大时缩到 2 秒一次;除此以外还要设置检测超时,假如设置 3 秒超时,超 3 秒没回复才会触发预警,避免短暂延迟误判故障。

但只看心跳不够 —— 有时节点网络通了,业务功能却已瘫痪,需业务健康检查补位。比如调用核心业务接口、模拟真实用户请求验证功能,同时监控响应时间、错误率等指标,若响应时间超 2 秒、错误率飙至 5% 以上,即便心跳正常,也判定节点 “不健康”。

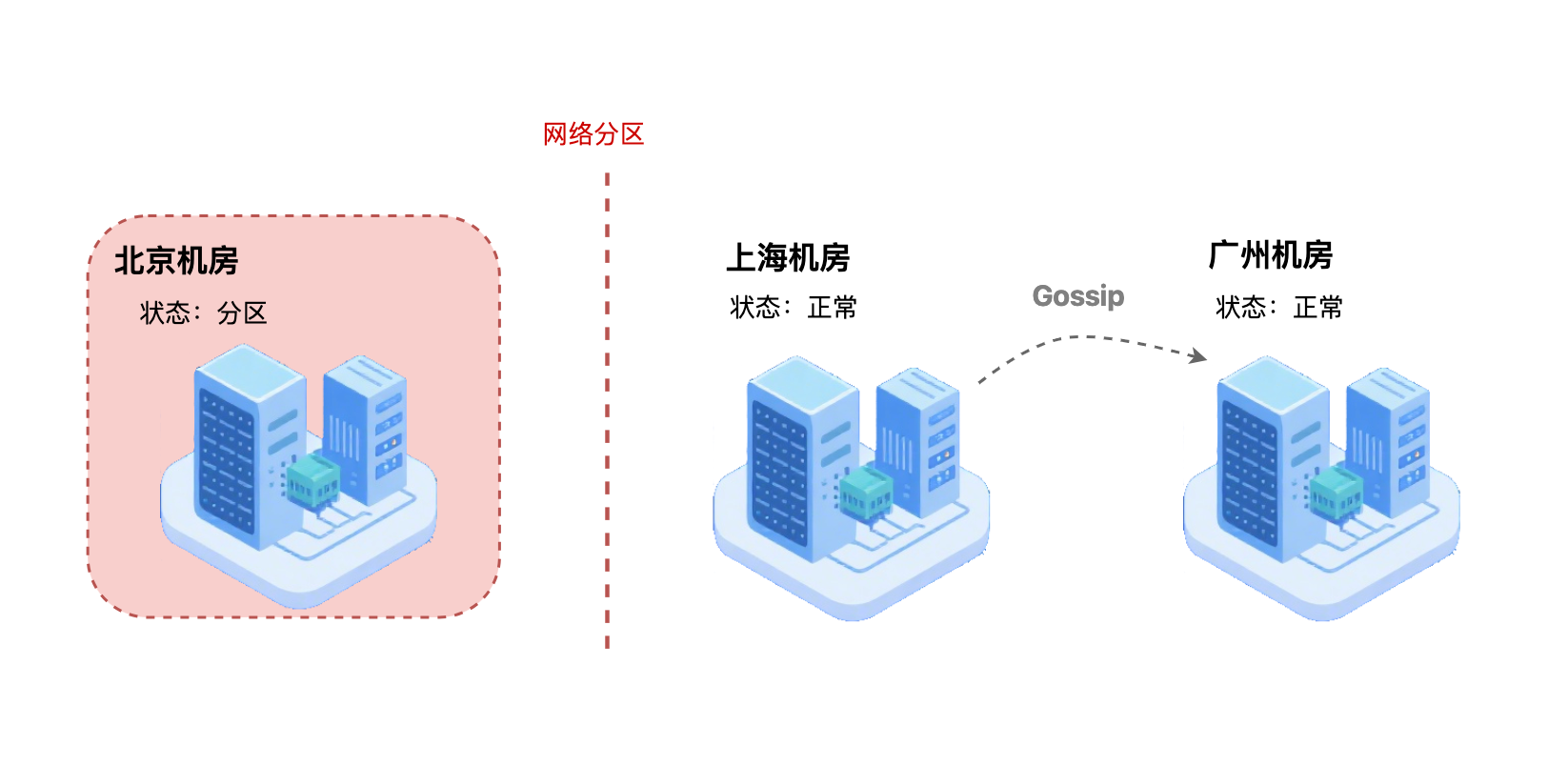

还有易忽略的网络分区情况:机房间网络断连,但各机房自身正常,需网络分区检测应对。常用 Gossip 协议实现,节点间像 “传话” 般传播状态,若某机房长时间收不到其他机房信息,可快速识别分区;同时做分区恢复检测和边界识别,既防脑裂,也为切换决策提供依据。

2. 切换决策机制

切换决策机制是异地多活架构中 “故障应对” 的核心环节,主要围绕三个关键问题展开:

问题1:故障发生时,该让系统自己决策还是人工介入?

本质是响应速度与安全风险的平衡。

- 若选自动切换,系统会按预设规则直接判定并执行切换,优势是服务恢复速度能到秒/分钟级;但缺点是风险高,一旦规则考虑不周,可能引发误切换。

- 若选半自动切换,系统会先报警,等人工确认,如运维人员核查故障真实性、评估影响范围后再执行切换。优势是安全性高,能避免误操作;但依赖人工处理时效,响应速度慢。

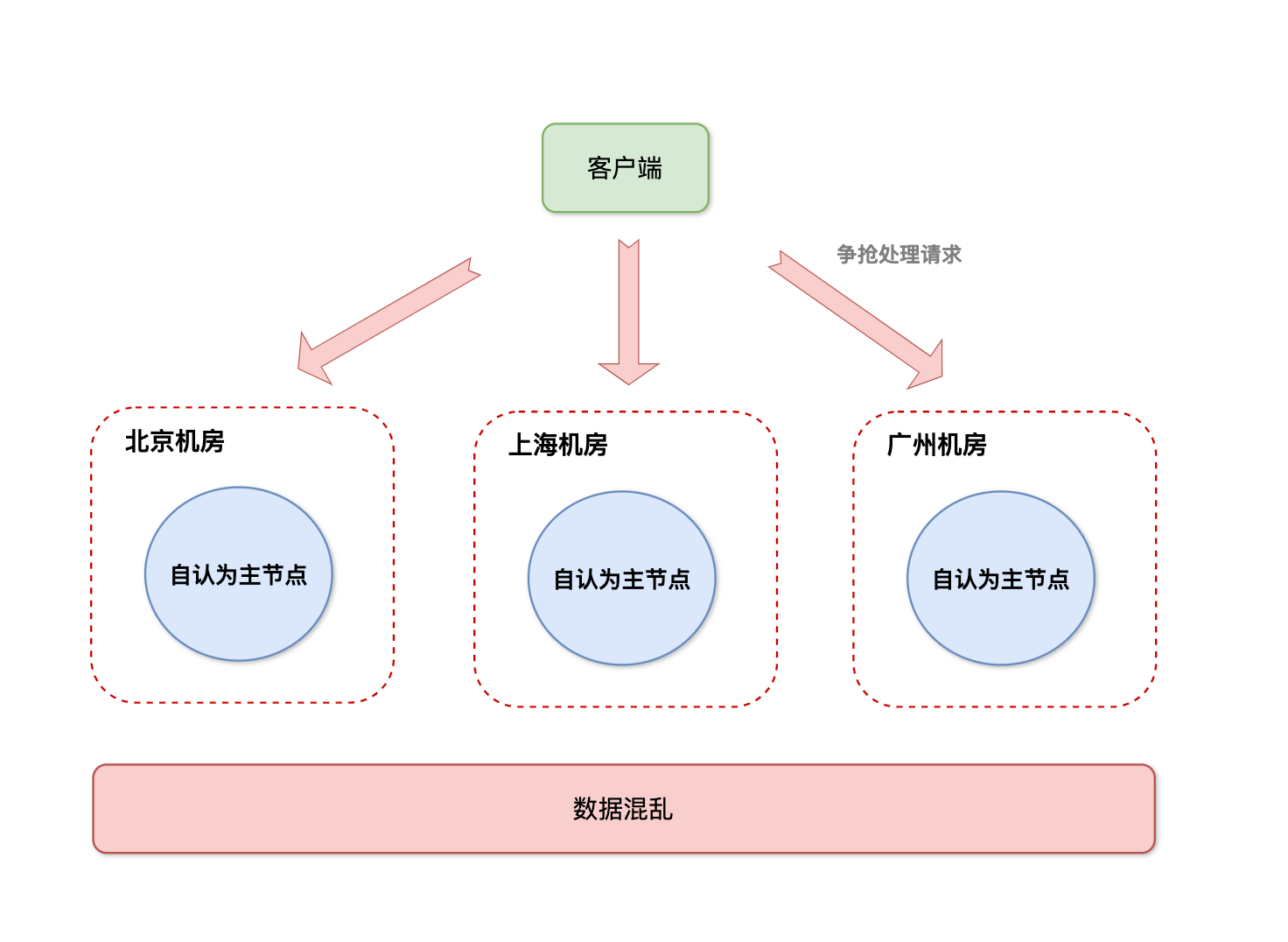

问题2:如何避免多节点 “争权”?也就是脑裂问题

所谓脑裂,就是多个机房同时认为自己是主节点,都抢着处理请求,最终导致数据混乱。

目前主流有三种解决思路:

1.Quorum 机制靠 “少数服从多数”(如 3 个节点需 2 个同意才切换)避免独断;

2.租约机制通过 “临时唯一授权” 确保单主;

3.仲裁节点则引入第三方 “裁判” 判定主节点归属。

问题3:选在什么时候切换最稳妥?

首先要选业务影响最小的时候,比如电商挑凌晨 2-4 点用户少的时段切换,少干扰交易;其次得优先保证数据一致,比如先确认故障节点没同步的数据已备份好,再切换,避免用户下单记录消失;最后也要尽量快,确认安全后就赶紧操作,减少用户感知到的卡顿。

3. 数据恢复策略

数据恢复是故障修复后让业务回归正轨的关键,核心解决三个问题:选增量还是全量恢复、如何校验数据无差错、怎样稳妥回切业务。

增量恢复 vs 全量恢复:

增量恢复:仅同步故障期间变化的数据(如上海机房新增的订单),无需传输全量内容,速度快、耗资源少,适合故障时间短、数据变化小的场景

全量恢复:同步所有业务数据(含用户信息、订单记录等),能最大程度保障数据完整,适合故障时间长、数据变更复杂的情况,不过速度慢、资源消耗大,可能影响临时承载节点的正常运行。

数据恢复后必做一致性校验:校验和比较(算 MD5、CRC 值,一致则数据未损坏)、业务逻辑校验(如订单支付金额非负、库存不小于已售)、历史数据对比(和故障前快照比,查订单 ID 是否缺失重复)。

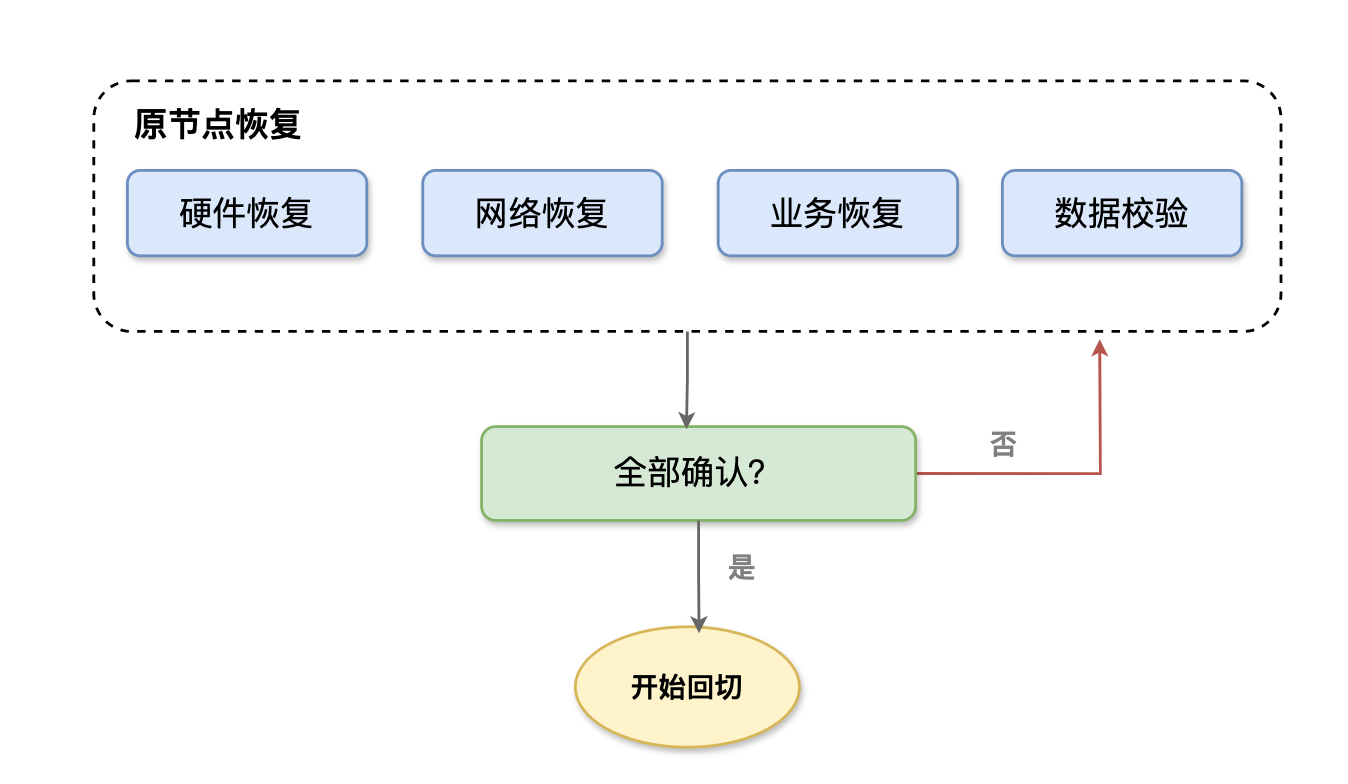

最后是回切策略 —— 当原故障节点(比如北京机房)恢复后,不能直接把所有流量切回去,需要循序渐进:谨慎回切原则是前提,必须确认原节点的硬件、网络、业务功能都完全恢复,且数据一致性校验通过后,才启动回切;

聊完了异地多活的核心技术 —— 像数据一致性怎么解决、数据冲突怎么发现和解决这些是架构能跑起来的 “内功”;而要让这套架构真正落地好用,还得搞定网络和成本这两件实际事。

网络上不用太复杂,就是让用户访问更流畅、数据传得更顺,比如就近分配资源、给数据 “减减肥” 少占带宽,再多备几条线路防断连;

成本控制上也要在在 “可用” 与 “省钱” 间找平衡,按需分配资源、让一套资源多业务共用,再靠自动化少费人力,这样既能保住架构的可用性,也能把钱花在刀刃上。

异地多活是 “权衡的艺术”

看到这里,大家应该能明白:异地多活不是 “追求完美”,而是 “适配业务”—— 所有技术方案的选择,本质都是在 “一致性与性能”“可用性与成本”“复杂度与稳定性” 之间做权衡,没有绝对的 “最优解”,只有 “最适合业务的解”。

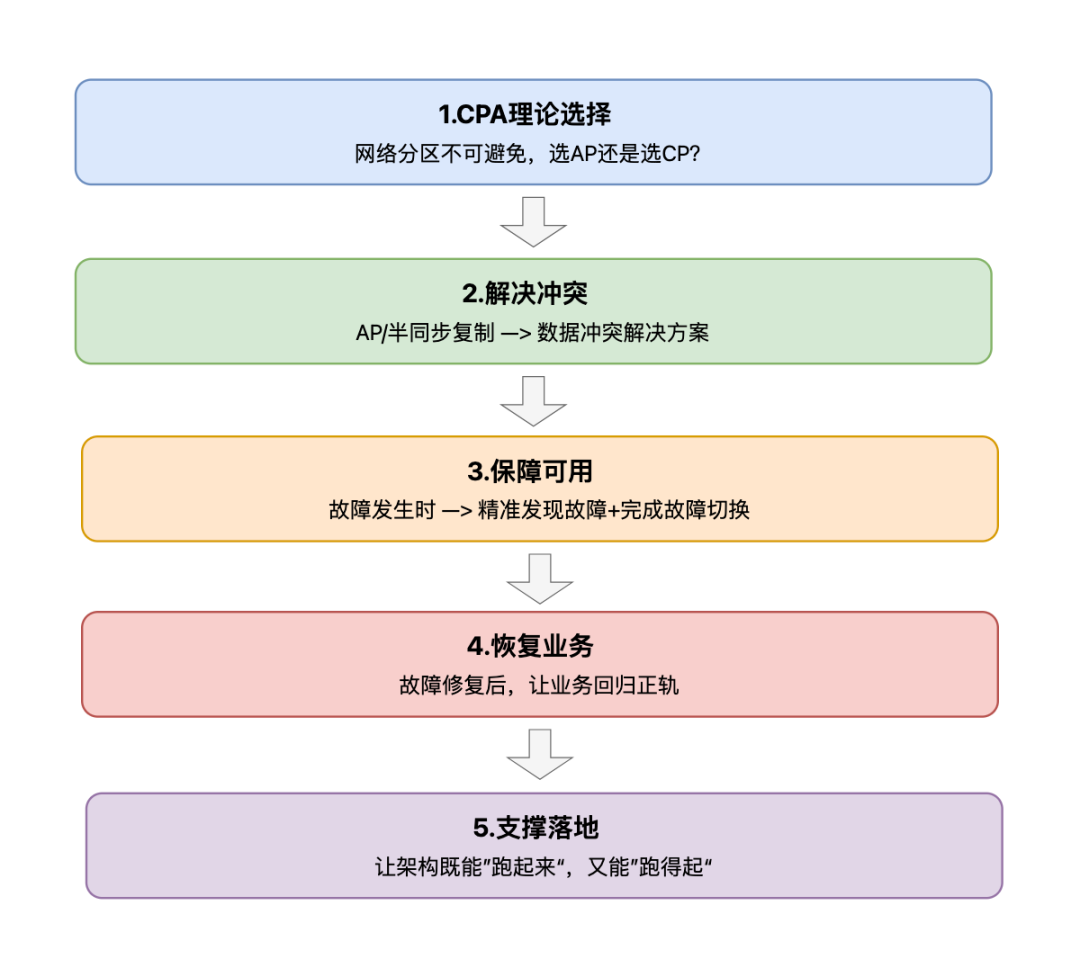

我们可以把核心技术串联成一条逻辑链:

1.基础原则:

CAP 理论告诉我们,异地多活必须接受 “网络分区不可避免”,因此首先要做的是 “选 CP 还是选 AP”—— 金融业务选 CP(同步复制保证数据一致),社交业务选 AP(异步复制保证服务可用),电商选半同步复制(平衡两者);

2.解决冲突:

若选了 AP 或半同步复制,就会面临数据冲突,这时用时间戳(简单场景)、版本号(分布式场景)、业务规则(复杂业务场景)来解决;

3.保障可用:

故障发生时,通过心跳 + 业务健康检查 + 网络分区检测 “精准发现故障”,再用自动 / 半自动切换(平衡速度与安全)、Quorum / 租约机制(防脑裂)、低峰期切换(减影响)完成故障切换;

4.恢复业务:

故障修复后,用增量 + 全量混合恢复(平衡速度与完整)、多维度校验(保数据正确)、灰度回切(防二次故障)让业务回归正轨;

5.支撑落地:

最后通过网络优化(降延迟、保稳定)和成本控制(按需分配、资源复用),让架构既能 “跑起来”,又能 “跑得起”。

面试指南:别当“理论派”,这样说才像“实战派”

讲完了异地多活的核心知识点,接下来讲讲如何应对面试。

异地多活是高可用架构面试的 “分水岭” ,既考 CAP理论、数据一致性这些硬知识,又问网络、成本这些落地细节,面试官就想看出你是不是真做过项目。

很多朋友在面试中总被问得一句接一句卡壳,其实只要学会”开头带节奏、落地说案例、关键露亮点”,就能轻松出彩。

一、开场别只说我做过,用业务痛点勾住面试官

千万别上来就说 “我负责了异地多活”,这样太生硬了!

先抛出业务痛点,再关联你的方案,让面试官觉得你做的事有价值。这里有 3 个现成话术模板,大家可以参考着用:

场景 1:应对城市级故障(适合电商、金融等核心业务)

“我负责的订单系统,之前是北京单机房部署。去年夏天北京暴雨导致机房断电,整个业务中断了 3 小时,损失了近 200 万订单。这次事故后,公司要求必须做‘城市级灾备’—— 也就是异地多活。我主导了从‘单机房’到‘北京 + 上海两地双活’的落地,核心目标是:任一城市机房故障,业务能在 1 分钟内恢复,数据不丢、不错。”

场景 2:解决跨地域用户体验(适合全国性业务)

“我们的 APP 在全国有 300 万日活,但用户反馈‘南方用户加载慢’—— 因为服务器只在北京,深圳用户访问接口延迟高达 120ms。为了优化体验,我设计了‘异地多活 + 就近访问’架构:北京、广州、成都各部署一套服务,用户自动连最近的机房,同时保证三地数据一致。最终南方用户的接口延迟降到 30ms,留存率提升了 5%。”

场景 3:中小团队的轻量落地(适合创业公司、非核心业务)

“之前在创业公司,老板想做异地多活但怕成本太高(预算只有 20 万)。我没搞复杂的‘三地五中心’,而是用‘核心数据异地备份 + 关键接口云部署’的轻量方案:北京的订单数据实时备份到阿里云上海节点,支付接口部署在上海云服务器,其他接口仍在本地。成本控制在 15 万内,核心业务的故障恢复时间从 4 小时降到 5 分钟。”

这样表述的话,面试官大概率会顺着问:

“两地双活的数据同步是怎么保证的?”

“就近访问具体是怎么实现的?”

咱们就可以自然地把话题引到自己准备好的内容上了。

二、核心模块:别堆技术名词,用 问题 - 方案 - 结果 讲

聊具体实现时,不太建议罗列技术名词“我用了半同步复制、Quorum 机制”,面试官最想听的是你怎么落地。要按这个路径展开:之前有啥问题 → 我怎么解决 → 效果咋样。每个点都带案例 + 数字,这才像实战派。

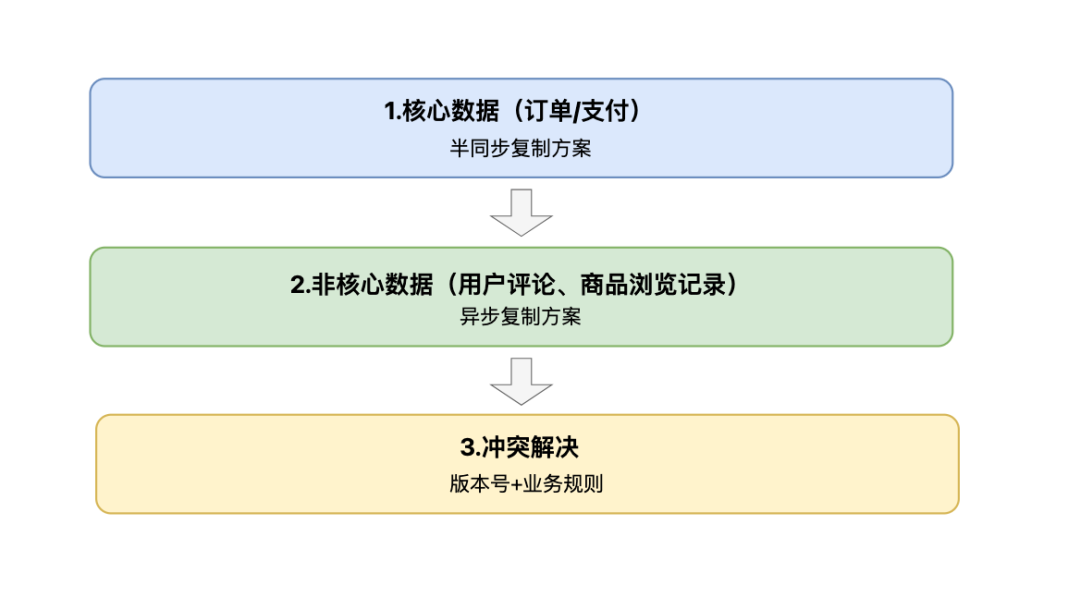

模块 1:数据一致性 — 别吹强一致,说适配业务

面试官最爱问 “你们怎么保证数据一致?CAP 怎么选?”

别纠结选 CP 还是 AP,说分级 + 动态调整 ,显得你更务实

“我们没有追求所有数据强一致,而是先给业务数据分了级:

- 核心数据像订单 / 支付,我们采用 '北京主库 + 上海 / 广州从库' 的半同步复制方案,配置 '3 选 2 确认' 机制。主库写完后,需至少 1 个从库确认接收,同步延迟控制在 200ms 内,即便是双 11 高峰期,核心数据也未出现丢失。

- 非核心数据比如用户评论、商品浏览记录,用的是异步复制方案,偏 AP方向— 主库写完马上返回,后台慢慢同步,虽有 1-2 秒延迟,但 QPS 从 2 万涨到 6 万,完全能满足业务需求;

- 还有冲突解决的问题,遇到两机房改同一商品库存的情况,我用”版本号 + 业务规则“的方案 — 版本高的优先,版本一样就让扣库存操作优先域加库存操作执行,防止超卖。之前每月 5 起超卖投诉,现在没了。

对了,还有个小细节和您分享:CAP 不是固定不变的,我们会根据业务场景动态调整 — 比如大促开始前 1 小时,会把核心数据切换成强同步模式,确保交易安全;大促结束后再切回半同步,这样既能保证关键时段的数据一致性,也不会浪费资源。”

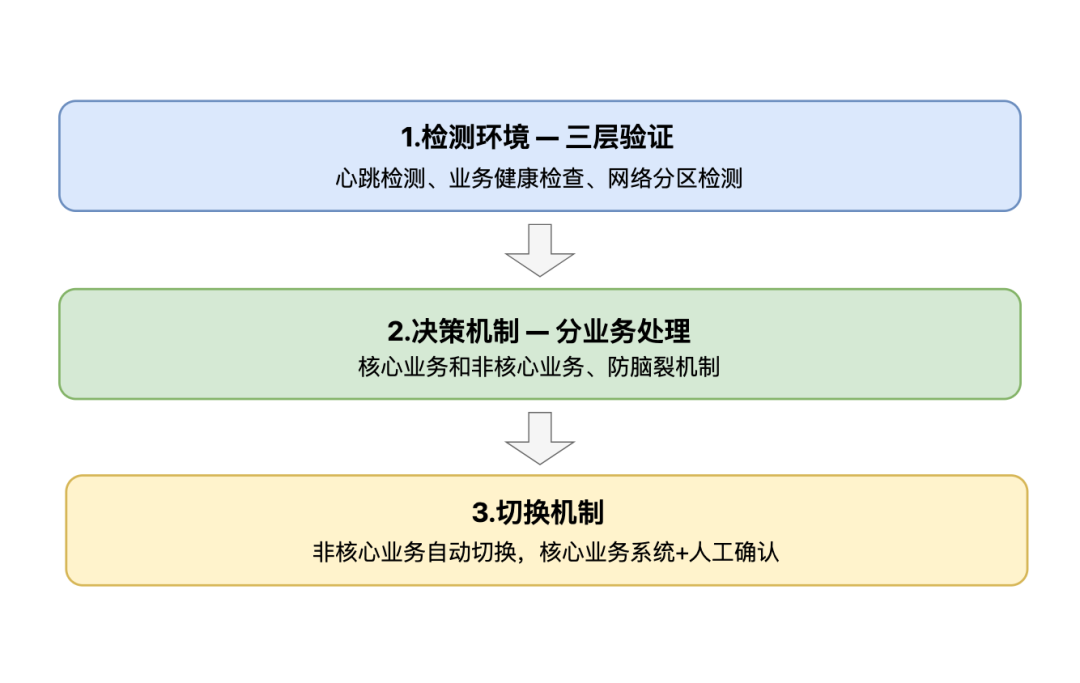

模块 2:故障切换 —— 从 “人工救火” 到 “自动无感”

被问 “机房挂了怎么切?用户有感觉吗?”

别只说自动切换,要讲全链路:

“之前切换要人工改 DNS、重启服务,至少要 30 分钟。后来我和团队搭建了 检测→决策→切换 自动化体系:

- 检测环境做了三层验证:每 5 秒发一次心跳,连续 3 次超时就触发预警;像订单接口响应超过 2 秒或错率超过 5% 就算业务挂了;最后用 Gossip 协议,10 秒收不到其他机房消息就识别成网络分区,避免误判;

- 决策的时候会分业务,非核心业务 1 秒内自动切换,用户基本没感觉;像支付这种核心业务,是半自动的 — 系统先预警,人工确认后 10 秒内触发切换,主要怕误判影响交易;

- 为了防脑裂,我们还在杭州部署了个独立的仲裁节点,要是北京、上海机房都觉得自己是主节点,就听仲裁节点的,一般会选负载低的那个。

去年上海机房出现过一次断网,支付业务大概 15 秒就完成了切换,成功率从 92% 回升到了 99.9%,就 3 笔订单失败,重试后就成功了;非核心业务 1 秒就切换好了,也没收到用户投诉。”

模块 3:网络优化 — 别说降延迟,说具体怎么降

问 “跨地域延迟怎么搞?带宽够吗?”

分用户访问和数据同步展开:

“异地网络就俩问题:延迟高、带宽紧。我是这么优化的

- 用户访问这边,用了智能 DNS 加 CDN。根据用户 IP 定位,比如深圳的用户自动连广州机房,延迟从 120ms 压到了 30ms;另外把商品图片、静态页面这些放到全国的 CDN 节点,用户能就近加载;最终APP 启动速度快了 30%;

- 数据同步这边,用了压缩 + 增量 + 优先级的策略 。先用 ProtoBuf 替代 JSON,再做一次 Gzip 压缩,数据体积能小 70%;同步的时候只传变化的字段,比如订单只传状态,不用传全量信息;还会给数据分优先级,核心数据走高带宽通道,日志这种非核心数据走低带宽。大促的时候,带宽占用从 100M 降到了 40M,没再出现过挤爆的情况。”

模块 4:成本控制 — 别光说省了钱,说说怎么省的

面试官其实很在意你盲目堆资源,所以要讲分级复用,这样才显得你会控制成本:

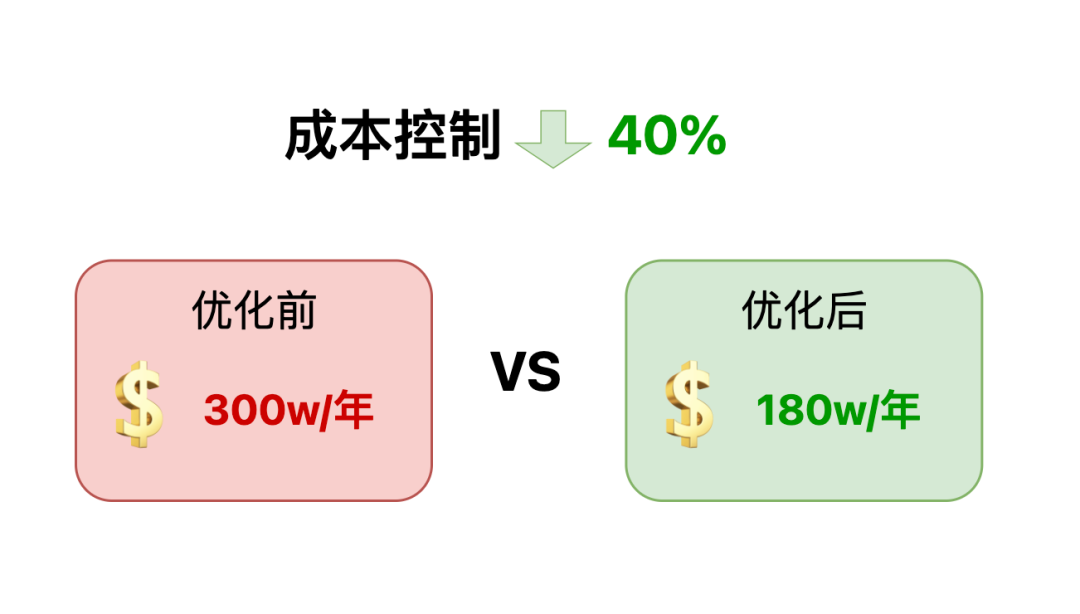

“很多人觉得异地多活贵,其实是没做好分级。我用核心优先、资源复用的思路,大概把成本降 了40%:

- 机房分级:北京 / 上海核心机房用物理机 + 专线,广州非核心用云服务器,凌晨 2-6 点关一半,能省不少资源;

- 资源复用:广州机房同时当北京和上海的备份节点,不用单独建备份机房,硬件成本省了 30%;

- 混合云:核心用私有云,非核心用公有云按需付费,比全用私有云省了 25% 左右。

优化前,异地多活一年成本大概是 300 万,优化后降到了 180 万,而且核心业务的可用性没受影响,全年中断时间只有 5 分钟。”

三、面试收尾:用一句话引导面试官追着你问

讲完了落地案例,最后可以说句总结,埋个新话题引子:

“其实异地多活的核心不是技术多牛,而是能不能解决业务问题 — 大公司追求零中断,小团队追求低成本可用。“

我还做了异地监控,用 Prometheus 盯数据同步延迟;还有新接口的多活适配规范,要求新接口必须兼容跨地域调用,这些细节也很关键。”

面试官大概率会问 “监控指标怎么设置?”“适配规范有啥?” 咱们就可以继续分享更多实战细节,让面试表现更扎实!

聊到这里,关于异地多活的核心知识点,牛哥就算盘完了;希望这些内容能帮你把异地多活的知识串成体系;无论是实战还是面试中,都能轻松应对!